Contextual Bandits verstehen: Ein Guide für dynamische Entscheidungsfindung

Contextual Bandits sind ein leistungsstarkes Framework im Bereich des maschinellen Lernens, das zunehmend an Bedeutung gewinnt, wenn es darum geht, Entscheidungen in Echtzeit zu optimieren. Im Gegensatz zu klassischen Algorithmen, die für alle User dieselbe Logik anwenden, beziehen Contextual Bandits den jeweiligen Kontext mit ein – und ermöglichen so eine gezielte, personalisierte Ansprache. Das macht sie besonders geeignet für Szenarien, in denen individuelle Personalisierungen und dynamische Entscheidungsprozesse im Vordergrund stehen.

Bei Kameleoon setzen wir Contextual Bandits ein, um Unternehmen dabei zu unterstützen, ihre Personalisierung weiter zu verbessern und bessere Ergebnisse aus Tests und Optimierungsmaßnahmen zu erzielen. Durch diesen Ansatz können Organisationen fundierte, datenbasierte Entscheidungen treffen, die sich laufend an das Verhalten und die Vorlieben der User anpassen.

In diesem Artikel werfen wir einen Blick auf folgende Themen:

- Was sind Contextual Bandits?

- Wie funktionieren Contextual Bandits?

- Warum sind Contextual Bandits so effektiv?

- Zentrale Herausforderungen und wichtige Überlegungen

- Wie Contextual Bandits die Leistungsfähigkeit von Kameleoon unterstützen

Was sind Contextual Bandits?

Ein Contextual Bandit ist ein Ansatz aus dem maschinellen Lernen, der Prinzipien des Reinforcement Learnings mit kontextbezogenen Informationen kombiniert, um Entscheidungen gezielt zu optimieren. Im Kern wählt das Modell eine bestimmte Aktion aus – etwa die Empfehlung eines Produkts oder das Ausspielen einer Anzeige – basierend auf Kontextdaten wie dem Standort des Users, dessen Browserverlauf oder der Tageszeit. Nach der Ausführung bewertet das Modell den Erfolg dieser Aktion (die sogenannte „Belohnung“) und passt seine Strategie an, um künftige Entscheidungen zu verbessern.

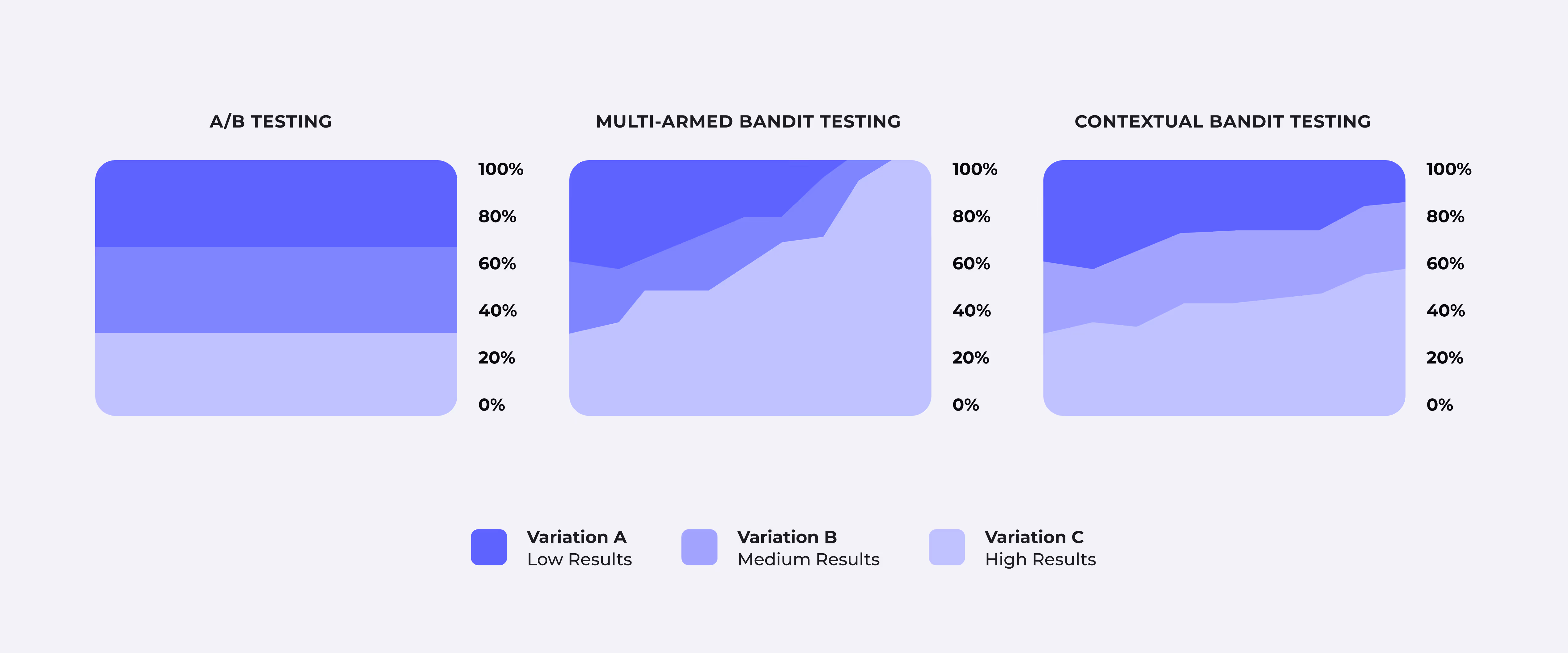

Der Unterschied zum klassischen Multi-Armed Bandit lässt sich so zusammenfassen:

- Beim Multi-Armed-Bandit-Problem erfolgen Entscheidungen ohne Kontext – jede Aktion basiert lediglich auf bisherigen Ergebnissen.

- Ein Contextual Bandit hingegen bezieht die aktuelle Situation mit ein, wodurch die Entscheidungen besser auf einzelne User oder Szenarien abgestimmt werden können.

Man kann es sich so vorstellen: Ein Multi-Armed Bandit ist wie eine statische Online-Anzeige, die jedem Besucher gleichermaßen gezeigt wird – unabhängig von dessen Interessen. Ein Contextual Bandit hingegen gleicht einer dynamischen Anzeige, die sich individuell anpasst – etwa basierend auf dem Surfverhalten, dem Standort oder der Uhrzeit.

Wie funktionieren Contextual Bandits?

Um zu verstehen, wie Contextual Bandits arbeiten, lässt sich ihr Prozess in vier zentrale Schritte unterteilen:

- Kontext erfassen: Zunächst sammelt das Modell kontextbezogene Informationen. Dazu gehören demografische Daten des Users, sein aktuelles Verhalten (zum Beispiel Produkte im Warenkorb) oder äußere Faktoren wie Tageszeit oder Gerätetyp.

- Auswahl der Aktion: Basierend auf diesem Kontext bewertet das Modell verschiedene mögliche Aktionen und prognostiziert, welche davon mit hoher Wahrscheinlichkeit zu einem positiven Ergebnis führt. Das kann zum Beispiel eine Produktempfehlung oder ein auf den User zugeschnittenes Rabattangebot sein.

- Beobachtung der Belohnung: Nach Ausführung der Aktion beobachtet das System die Reaktion des Users – etwa einen Klick, einen Kauf oder auch gar keine Interaktion. Diese Rückmeldung wird als sogenannte „Belohnung“ gespeichert.

- Lernen und Anpassen: Das Modell nutzt diese Rückmeldung, um seine Entscheidungslogik zu verfeinern. So verbessert es mit der Zeit seine Vorhersagen für ähnliche Kontexte.

Durch dieses kontinuierliche Lernen schaffen Contextual Bandits einen effektiven Ausgleich zwischen Exploration (neue Optionen ausprobieren, um Daten zu sammeln) und Exploitation (bewährte Strategien nutzen, um bestmögliche Ergebnisse zu erzielen).

Warum sind Contextual Bandits so effektiv?

Ihre wahre Stärke liegt in der Fähigkeit, sich flexibel an individuelle User und wechselnde Situationen anzupassen. Anders als statische Regeln oder fest programmierte Algorithmen reagieren Contextual Bandits dynamisch – und sind dadurch in vielfältigen Anwendungsbereichen besonders wirkungsvoll.

Ein paar Beispiele:

- Sie personalisieren Experiences in Echtzeit – auch bei Millionen von Usern – und berücksichtigen dabei den spezifischen Kontext jeder einzelnen Interaktion.

- Selbst mit begrenzten Daten erkennen sie schnell Muster und verbessern kontinuierlich ihre Entscheidungsfindung.

- Indem sie sich auf jene Aktionen konzentrieren, die den größten „Reward“ bringen, reduzieren sie Streuverluste und vermeiden ineffektive Maßnahmen.

Zentrale Herausforderungen und wichtige Überlegungen

So viel Potenzial Contextual Bandits auch bieten – ihre erfolgreiche Umsetzung bringt einige Herausforderungen mit sich, die bedacht werden sollten:

- Balance zwischen Exploration und Exploitation: Das Modell muss kontinuierlich abwägen, wann es neue Optionen testen sollte (Exploration) und wann es auf bereits bewährte Maßnahmen setzen kann (Exploitation). Nur mit dem richtigen Gleichgewicht bleibt der Lernprozess aktiv, ohne kurzfristige Erfolge aus den Augen zu verlieren.

- Das Cold-Start-Problem: Bei neuen Usern oder wenig vorhandenen Daten fehlt es dem Modell zunächst an Kontext, um fundierte Entscheidungen zu treffen. Hier können allgemeine Startwerte oder initiale Heuristiken helfen, diesen Anfangswiderstand zu überwinden.

- Fairness und Verzerrung (Bias): Ein wichtiger Aspekt bei der Modellierung ist, sicherzustellen, dass keine Nutzergruppen systematisch bevorzugt oder benachteiligt werden. Fairness im Design ist entscheidend, um allen Zielgruppen ein ausgewogenes Erlebnis zu bieten.

Darüber hinaus sollten Unternehmen in gründliches Testing und Monitoring investieren, um sicherzustellen, dass sich das Modell wie gewünscht weiterentwickelt – und dabei keine unbeabsichtigten Effekte auftreten.

Wie Contextual Bandits die Leistungsfähigkeit von Kameleoon unterstützen

Mit der Einführung von Contextual Bandits eröffnet Kameleoon neue Möglichkeiten in den Bereichen Personalisierung und Experimentation – durch dynamische Anpassungen an das Verhalten einzelner User in Echtzeit.

- Anstelle klassischer A/B-Tests verteilen Contextual Bandits den Traffic flexibel – basierend auf dem jeweiligen Nutzerkontext. Das führt zu schnelleren Erkenntnissen und deutlich wirksameren Ergebnissen.

- Durch die Nutzung aktueller Kontextdaten können Unternehmen Empfehlungen ausspielen, die stärker auf den einzelnen User zugeschnitten sind – und so Engagement und Conversion-Raten deutlich steigern.

- Contextual Bandits identifizieren jene User, die mit hoher Wahrscheinlichkeit positiv auf ein neues Feature oder eine Promotion reagieren – und priorisieren deren Ausspielung. So wird die Wirkung maximiert, während das Risiko minimiert wird.

Diese Anwendungsbeispiele zeigen deutlich: Contextual Bandits ermöglichen eine deutlich präzisere, kontextbezogene Entscheidungsfindung – perfekt abgestimmt auf individuelle Nutzerbedürfnisse und geschäftliche Ziele.

So startest du mit Contextual Bandits in Kameleoon

Die Aktivierung von Contextual Bandits in Kameleoon ist ganz einfach:

- Gehe zum Bereich „Bearbeiten“ deines Experiments.

- Klicke auf „Traffic-Zuweisung“.

- Öffne das Dropdown-Menü unter „Wählen Sie die Methode der Zuweisung aus“.

- Wähle „Contextual Bandit“ aus.

Wenn dein Account AI Predictive Targeting (entweder im Rahmen eines kostenpflichtigen Plans oder einer Testversion) beinhaltet, kannst du die Leistung der Contextual Bandits weiter verfeinern – indem du eigene Daten hinzufügst oder entfernst.

Neue Möglichkeiten mit Contextual Bandits

Contextual Bandits stehen allen Kameleoon Kunden zur Verfügung – und bieten ein leistungsstarkes Werkzeug, um Personalisierung und Entscheidungsfindung auf das nächste Level zu heben.

Für Unternehmen, die ihre Strategien noch weiterentwickeln möchten, bietet Kameleoon eine erweiterte Version der Contextual Bandits im Rahmen der AI Predictive Targeting-Funktion. Diese ermöglicht die Integration eigener Datensätze – für noch präzisere Entscheidungen, passgenau auf individuelle Geschäftsziele abgestimmt.

Die Standardversion, die allen Kunden zur Verfügung steht, nutzt über 40 native Datenpunkte, die Kameleoon automatisch sammelt – darunter Nutzerverhalten, Geräteinformationen und Umgebungsfaktoren. So entsteht eine wirkungsvolle, skalierbare Echtzeit-Personalisierung.

Contextual Bandits markieren einen wichtigen Fortschritt im Bereich des maschinellen Lernens – und bieten eine intelligentere, anpassungsfähigere Methode zur Optimierung von Entscheidungen.