Was ist A/B-Testing?

1. Was ist A/B-Testing?

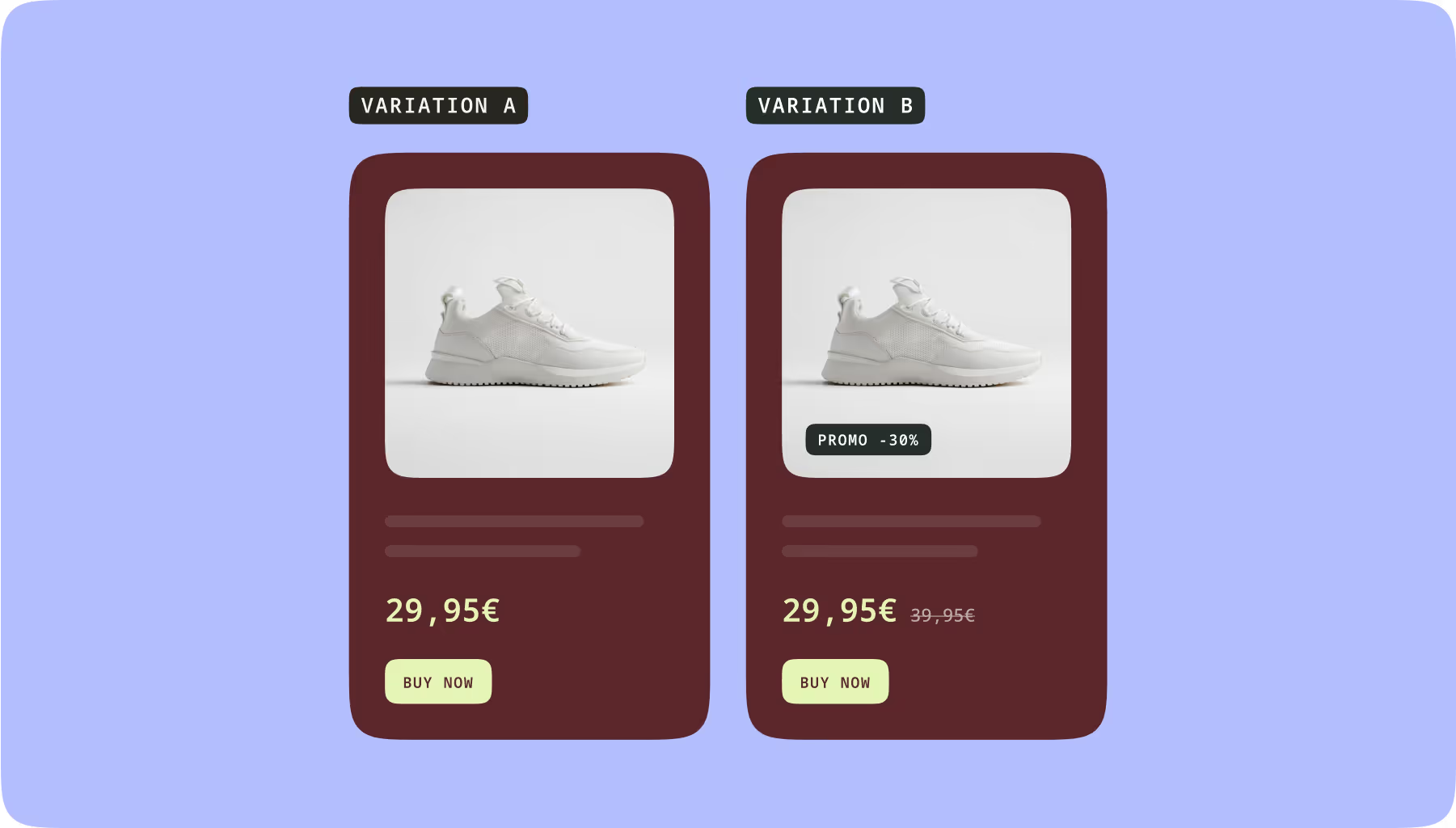

Ein A/B-Test ist ein Online-Experiment, mit dessen Hilfe Sie feststellen können, welche Version einer Webseite oder einem Seitenelement, nach den von Ihnen festgelegten messbaren Kriterien am besten funktioniert.

Einfach ausgedrückt: Mit einem A/B-Test können Sie auf Grundlage einer statistischen Analyse feststellen, welche Variante bei Ihren Kunden besser ankommt.

Um einen A/B-Test durchzuführen, müssen Sie:

- Ihre Besucher nach dem Zufallsprinzip in zwei oder mehr gleich große Gruppen einteilen.

- Diesen Gruppen über einen bestimmten Zeitraum verschiedene Varianten Ihrer Assets zeigen.

- Die relative Leistung der einzelnen Versionen in Bezug auf Ihre Kennzahlen, wie z. B. Conversions oder Verkäufe, vergleichen.

- Die Ergebnisse analysieren, um festzustellen, ob es sich lohnt, die Änderungen dauerhaft umzusetzen.

2. Was sind die Vorteile von A/B-Tests?

Die Anwendung von A/B-Tests hat viele Vorteile.

Fünf gute Gründe für A/B-Testing:

Höhere Conversions

Durch das Testen verschiedener Varianten können Sie Ihre Website kontinuierlich optimieren, um die User Experience und die allgemeine Conversion Rate zu verbessern.

Bessere Einbindung der Besucher

Mit A/B-Tests können Sie Ihren Besuchern eine außergewöhnliche User Experience bieten, um es an Ihr Unternehmen zu binden und langfristig zu halten.

Verbesserte Besucher-Insights

Analysieren Sie, wie sich die verschiedenen Elemente Ihrer Seiten auf das Verhalten Ihrer Besucher auswirken und erfahren Sie mehr über deren Bedürfnisse und Erwartungen.

Entscheidungen auf der Grundlage quantifizierter Ergebnisse treffen

Hypothesen mit A/B-Tests zu belegen hilft Ihnen, alle Risikofaktoren zu reduzieren. Sie können Entscheidungen auf der Grundlage zuverlässiger Daten und Statistiken, anstatt auf der Basis subjektiver Einschätzungen treffen.

Optimierte Produktivität und Budgets

Nutzen Sie die Erkenntnisse aus Ihren A/B-Tests, um Ihren Aufwand und Ihr Budget darauf zu lenken, was für jedes Zielgruppensegment am besten funktioniert.

Viele Fragen können Sie mit einem A/B-Test beantworten:

- Welche Elemente fördern Verkäufe und Conversions oder beeinflussen das Nutzerverhalten?

- Welche Schritte Ihres Conversion-Funnels sind nicht erfolgreich?

- Sollten Sie neue Funktion einführen oder nicht?

- Sollten Sie lange oder kurze Formulare verwenden?

- Welcher Titel für Ihren Artikel generiert mehr Shares?

3. Wie A/B-Testing von unterschiedlichen Teams genutzt werden kann

A/B-Tests sind aufgrund ihrer Flexibilität sehr wertvoll. Daher können viele verschiedene Teams aussagekräftige Erkenntnisse aus gut konzipierten A/B-Tests gewinnen.

Marketing Teams

Marketingteams verwenden A/B-Tests, um die Leistung ihrer Kampagnen über eine Vielzahl von Kanälen zu verbessern.

Sie können testen, welche von mehreren verschiedenen Handlungsaufrufen auf einer Landingpage am besten funktionieren. Sie können auch verschiedene User Experiences testen – so kann festgestellt werden, welche davon die KPIs am meisten steigern.

Product Teams

A/B-Tests sind ein hervorragendes Instrument zur Verbesserung der Nutzerbindung und des Engagements im Zusammenhang mit einem Produkt.

Produktteams können verschiedene Onboarding-Prozesse testen um zu sehen, welcher dazu führt, dass Kunden mehr Meilensteine erreichen. Verschiedene Versionen eines Features können ebenfalls getestet werden. Dieser Prozess wird als Feature Experimentation bezeichnet und erfreut sich bei Produkt gesteuerten Unternehmen zunehmender Beliebtheit.

Growth- und Experimentation Teams

Growth- und Experimentation Teams können testen, welche Landingpage-Varianten zu den meisten Neuanmeldungen führen. Ansonsten kann auch ausgewertet werden, welches Productpage-Design zu den wenigsten Warenkorbabbrüchen führt.

4. Arten von A/B-Tests

Die gängigsten Arten von A/B-Tests, welche heute von verschiedenen Teams verwendet werden:

Split-Testing

Split-Tests sind eine spezielle Art von A/B-Tests, bei denen Sie die Testpersonen auf unterschiedliche oder geteilte URLs schicken. Der Split wird vor diesen Zielgruppen verborgen.

Split-Tests werden manchmal als Synonym für A/B-Tests verwendet, der Unterschied besteht jedoch darin, dass bei klassischen A/B-Tests die Zielgruppen verschiedene Versionen unter derselben URL sehen.

Multivariates Testing (MVT)

Multivariates Testen (oder MVT) ist eine A/B-Testmethode, mit der Sie während eines Experiments mehrere Variationen verschiedener Elemente gleichzeitig testen können.

Sie könnten zum Beispiel Kombinationen von Kopfzeilen, Beschreibungen und zugehörigen Produktvideos testen. In diesem Fall lassen Sie mehrere Seiten- oder App-Varianten generieren, um alle verschiedenen Kombinationen dieser Änderungen auszuprobieren und die beste zu ermitteln.

.avif)

Der große Nachteil von multivariaten Tests ist, dass sie eine enorme Menge an Traffic benötigen, damit die Ergebnisse statistisch aussagekräftig sind.

Bevor Sie mit einem multivariaten Testprojekt beginnen, sollten Sie daher vorher überprüfen, ob Ihre Testgruppe groß genug für repräsentative Ergebnisse ist.

A/A-Testing

Mit A/A-Tests können Sie zwei identische Versionen eines Elements testen. Die Besucher Ihrer Website werden in zwei Gruppen aufgeteilt, wobei jede Gruppe dieselbe Variante zu sehen bekommt.

Mithilfe von A/A-Tests lässt sich feststellen, ob die Conversion Rates in den beiden Gruppen ähnlich sind und bestätigen, dass Ihre Lösung korrekt funktioniert. Es ist auch eine gute Möglichkeit, Bugs und Ausreißer zu identifizieren, die sich auf die Ergebnisse auswirken.

Multi-Armed Bandit-Testing (Dynamische Trafficaufteilung)

Beim Multi-Armed Bandit-Testing – oft auch dynamische Traffic-Aufteilung genannt – leitet Ihr Algorithmus Ihr Publikum automatisch und schrittweise auf die Gewinnervariante um.

Der Gewinner wird durch die von Ihnen zu Beginn des Tests festgelegten Kennzahlen bestimmt.

Feature-Testing

Feature Testing – oder Feature Experimentation – umfasst die Erstellung mehrerer Funktionsversionen in Ihrer Codebasis.

Während Sie möglicherweise Entwickler benötigen, um Features für Sie zu schreiben, ermöglichen einige No-Code- oder Low-Code-Feature-Management-Tools nicht-technischen Benutzern wie Produktmanagern, Feature-Experimente unabhängig zu erstellen.

Wenn Sie einen Feature-Test einrichten, erstellen Sie eine Feature Flag in Ihrem Code, das Benutzer zu verschiedenen Code-Versionen weiterleitet. Feature-Tests sind ein Mittelweg zwischen der Implementierung eines clientseitigen Tests und eines serverseitigen Tests.

5. Statistische Modelle für A/B-Tests

Ein A/B-Test beruht auf statistischen Methoden. Sie müssen zwar nicht alle mathematischen Zusammenhänge kennen, um aussagekräftige Ergebnisse zu erzielen - grundlegende statistische Kenntnisse helfen allerdings, qualitativ bessere Tests zu erstellen. A/B-Testing-Lösungen verwenden zwei statistische Hauptmethoden. Jede ist für einen anderen Anwendungsfall geeignet.

Frequentistische Methode

Bei der frequentistischen Methode wird ein Konfidenzniveau ermittelt, das die Zuverlässigkeit Ihrer Ergebnisse misst. Bei einem Konfidenzniveau von 95 Prozent oder mehr haben Sie beispielsweise eine 95-prozentige Chance, dass die Ergebnisse korrekt sind.

Der Nachteil der frequentistischen Methode ist, dass sie einen „festen Zeithorizont“ hat, was bedeutet, dass das Konfidenzniveau bis zum Ende des Tests keinen Wert hat.

Bayes'sche Methode

Die Bayes'sche Methode liefert zu Beginn des Tests eine Ergebniswahrscheinlichkeit, sodass man nicht bis zum Ende des Tests warten muss, um einen Trend zu erkennen und die Daten zu interpretieren.

Die Herausforderung bei der Bayes'schen Methode besteht darin, dass man wissen muss, wie das geschätzte, währenddessen angegebene Konfidenzintervall zu lesen ist. Mit jeder zusätzlichen Conversion steigt das Vertrauen in die Wahrscheinlichkeit einer zuverlässigen Gewinnvariante.

Frequentistisch vs. Bayes'sche: Wie entscheiden Sie sich?

Die Entscheidung zwischen einem frequentistischen und einem bayesianischen Ansatz hängt von mehreren Faktoren ab:

- Wie viel wissen Sie über ähnliche, in der Vergangenheit durchgeführte Experimente?

- Wie sicher sind Sie, dass Ihr neues Experiment den vergangenen Experimenten wirklich ähnlich ist?

Nehmen wir an, Sie experimentieren mit einer ähnlichen Nutzerpopulation über einen ähnlichen Zeitraum mit demselben Merkmal wie in früheren Tests. In diesem Fall kann eine Bayes'sche Analyse schneller zu guten Ergebnissen führen.

Wenn Sie hingegen eine neue Funktion zum ersten Mal oder mit einem anderen Nutzersegment testen, sind diese Priors möglicherweise nicht relevant. Je weniger ein Test einem früheren Test ähnelt, desto besser ist es, mit einer rein frequentistischen Analyse neu zu beginnen.

6. Serverseitiges vs. clientseitiges A/B-Testing

Im Allgemeinen können Sie Ihren Test auf zwei Seiten Ihres Netzwerks durchführen: serverseitig oder clientseitig.

- Clientseitige Tests erfordern weniger technische Kenntnisse und eignen sich daher beispielsweise gut für Digital Marketer oder Growth-Teams, die gerade erst mit A/B-Testing beginnen. Sie ermöglichen es den Teams, agil zu sein, Experimente schnell durchzuführen und Engpässe zu vermeiden, sodass sie schneller Testergebnisse erhalten.

- Serverseitige Tests erfordern technische Ressourcen und oft eine komplexere Entwicklungsunterstützung. Sie ermöglichen jedoch leistungsfähigere, skalierbare und flexible Experimente.

Welchen Ansatz Sie für einen bestimmten Test wählen, hängt von der Unternehmensstruktur, den internen Ressourcen, Ihrem Entwicklungslebenszyklus und der Komplexität der Experimente ab.

Clientseitiges Testing

Bei einem clientseitigen Test wird der Webcode direkt im Browser des Endbenutzers modifiziert. Der Webcode für die zu testende Seite wird vom Server an den Browser des Endbenutzers weitergeleitet, wo ein Skript im Code bestimmt, welche Version der Benutzer zu sehen bekommt.

Dies geschieht unabhängig vom Browser (Chrome, Firefox, Safari, Opera usw.) im laufenden Betrieb.

VORTEILE VON CLIENTSEITIGEN TESTS

- Einfacher Einstieg mit wenigen technischen Kenntnissen.

- Kann für die schnelle Bereitstellung vieler Arten von Frontend-Tests und Personalisierungen verwendet werden, oft mit einem grafischen WYSIWYG-Editor.

- Erfordert keine Entwicklerressourcen oder Backend-Code.

- Ermöglicht Unternehmen die Durchführung einer Vielzahl komplexer Experimente, einschließlich multivariater Tests und Personalisierung über mehrere Seiten hinweg.

- Einfachere Beauftragung von Agenturen und CRO-Fachleuten zur Durchführung von clientseitigen Tests.

- Es können leicht Tests auf der Grundlage von Browserdaten erstellt werden.

NACHTEILE VON CLIENTSEITIGEN TESTS

- Andere Experimentiermöglichkeiten sind begrenzt.

- Es können keine Funktionen, Backend-Logiken oder Algorithmen clientseitig getestet werden.

- Kann nicht für das Testen mobiler Apps verwendet werden.

- Kann einen Flickereffekt verursachen, wenn das Snippet schlecht konstruiert oder installiert ist.

- Kann die Page-load-Performance verlangsamen.

- Datenschutzmaßnahmen, wie z. B. Apples ITP, können die Daten, die Experimentier-Spezialisten sammeln und auf die sie sich verlassen, einschränken.

- Ein schlecht gebauter WYSIWYG-Grafikeditor kann bei einer Single-Page-Application (SPA) nur schwer funktionieren

Serverseitiges Testing

Wenn Sie Tests serverseitig ausführen, werden diese nicht im Browser des Besuchers, sondern in der Backend-Infrastruktur erstellt.

VORTEILE VON SERVERSEITIGEN TESTS

- Bessere Kontrolle über die Elemente der Tests.

- Größere Freiheit bei der Auswahl der zu testenden Elemente, einschließlich der Elemente, die eine Verbindung zur Back-End-Datenbank oder den Zugriff auf den Code hinter den Kulissen erfordern.

- Eliminiert den Flickereffekt beim Testen.

- Ermöglicht das Experimentieren mit mobilen Apps.

- Keine Auswirkungen auf die Ladegeschwindigkeit oder Leistung der Seite.

- Kann als Absicherung gegen mögliche clientseitige Komplikationen aufgrund der Einschränkung von Website-Besucherdaten dienen.

NACHTEILE VON SERVERSEITIGEN TESTS

- Erfordert Entwicklerressourcen zum Entwerfen und Codieren von Tests. Diese technischen Ressourcen sind oft begrenzt und die Abhängigkeit von ihnen kann Testprogramme verlangsamen.

- Entwickler müssen Integrationen von Drittanbietern konfigurieren und pflegen, um eine präzise Zielgruppenansprache mit externen Segmenten zu ermöglichen oder um Testdaten mit anderen Plattformen zu synchronisieren.

- Sie müssen Software Development Kits (SDKs) pflegen oder eine Experimentierplattform nutzen, die dies für Sie übernimmt.

- Kann nicht einfach ausgelagert werden, da ein Entwickler benötigt wird, der den Aufbau und die Technik Ihrer Website versteht.

- Begrenzte Möglichkeiten für das Targeting, da es schwierig ist, auf In-Session-Daten der Besucher, d. h. Browserdaten, zuzugreifen und sie für die Erstellung von A/B-Tests zu verwenden.

Der hybride Testingansatz: Das Beste aus client- und serverseitigen Tests zusammenbringen

Eine dritte Option ermöglicht es Experimentier-Spezialisten, von clientseitigen Funktionen zu profitieren, auch wenn serverseitige Tests durchgeführt werden. Bei Hybrid Experimentation erhalten Benutzer das Beste aus beiden Ansätzen.

Bei Hybrid Experimentation werden sowohl clientseitige (JavaScript) als auch serverseitige (SDK) Funktionen verwendet, um die Durchführung von Experimenten für alle Arten von Teams wertvoller und einfacher zu machen. Mit einem Hybridmodell können Teams serverseitige Experimente durchführen, ohne wertvolle Entwicklerressourcen zu verbrauchen.

Hybride Experimente ermöglichen es Marketingfachleuten, Produktmanagern und Entwicklern:

- In einer einzigen, einheitlichen Plattform zu arbeiten und dabei Tools zu verwenden, die ihnen allen vertraut sind.

- Tracking und Reporting besser zu verwalten.

- Die Abhängigkeit der Entwicklerteams von der Erstellung neuer Skripte und der Pflege von Integrationen in externe Tools zu vermeiden.

- Die Gesamteffizienz zu verbessern und die teamübergreifende Zusammenarbeit bei Experimenten zu erhöhen.

Kameleoon ist die einzige hybride Experimentierplattform, die Ihnen die Möglichkeit bietet, serverseitige Experimente in Kombination mit clientseitigen Funktionen zu kreieren. Diese Plattform lässt sich mühelos in Ihren vorhandenen Tech-Stack einbinden, um umfassende Analyse und Aktivierung zu ermöglichen.

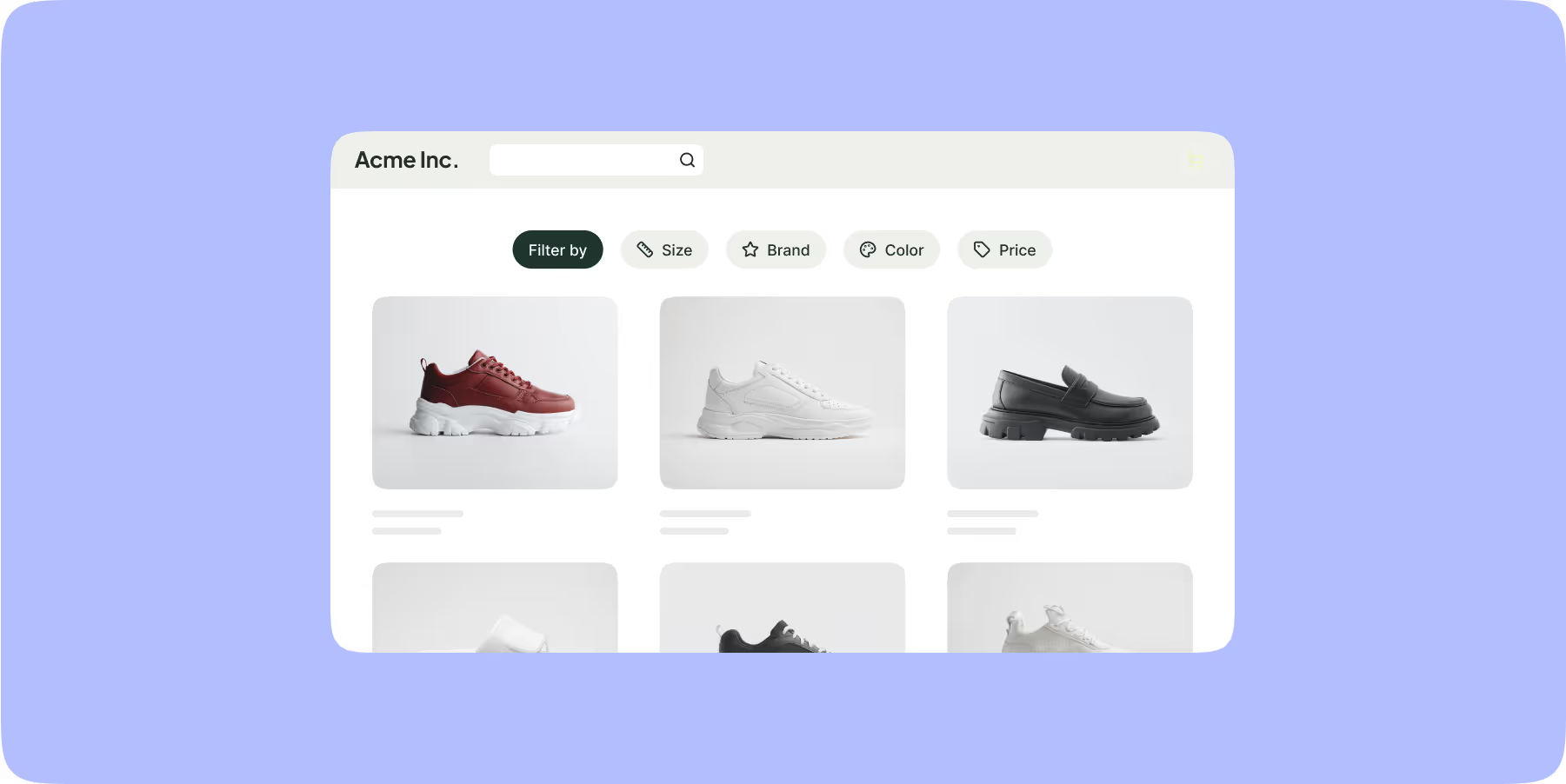

7. Was kann auf der Website oder in der App mit A/B-Testing getestet werden?

Sie können praktisch alles an Ihrer Website, App oder Customer Journey testen. Die Frage ist nur, wie Sie es testen.

Wie wir bereits herausgefunden haben, sind einige Tests besser clientseitig und andere lieber serverseitig durchzuführen.

IDEEN FÜR CLIENSTEITIGES TESTING

Clientseitige Tests eignen sich hervorragend für das Testen von Elementen, die im Browser des Kunden gerendert werden, z. B.:

- Seitentitel

- Banner

- Textblöcke

- Verschiedene CTAs

- Bilder

- Testimonials

- Links

- Produktbeschriftungen

IDEEN FÜR SERVERSEITIGES TESTING

Was Sie clientseitig testen können, können Sie auch serverseitig testen. Sie brauchen hierfür lediglich mehr Unterstützung in der Entwicklung, um Ihre Testumgebung zu pflegen. Sie können auch eine hybride Testumgebung aufbauen, in der Sie verschiedene Experimente durchführen.

Die Tests, die Sie nur serverseitig durchführen können, betreffen in der Regel Teile Ihrer Backend-IT-Infrastruktur, auf die der Browser des Kunden nicht zugreifen kann. Wenn Sie eine Anwendung testen, die nicht bei jedem Ladevorgang auf dem Gerät des Benutzers gerendert wird, sind Ihre Möglichkeiten meist auf serverseitige Tests beschränkt.

Serverseitige A/B-Tests können Versionen von:

- Algorithmen,

- Omnichannel-Erlebnisse,

- Dynamische Inhalten, insbesondere wenn sie von externen Quellen geladen werden,

- oder Anpassungen der Datenbankleistung sein.

Serverseitige Tests können dabei helfen, Tracking-Beschränkungen zu umgehen, die von Apps auf den Geräten von Benutzern auferlegt werden (wie z. B. Apples Funktion Intelligent Tracking Prevention (ITP) auf iOS-Geräten).

8. Einführung von A/B-Tests in Ihrem Unternehmen

Die Einführung von A/B-Tests in Ihrem Unternehmen erfordert einen Top-down-Ansatz. Im Folgenden finden Sie drei Punkte, die Sie beachten sollten, um Ihr Experimentierprogramm zu entwickeln.

1. Aufbau einer Experimentierkultur

Eine der besten und langfristigen Strategien zur Förderung von A/B-Tests in Ihrem Unternehmen besteht darin, eine Kultur des Experimentierens zu pflegen. Der Aufbau einer Teamkultur, die Experimente und einen verantwortungsvollen Umgang mit Daten schätzt ist unerlässlich, wenn Sie eine personalisierte und optimierte User Experience für alle Kunden schaffen wollen.

Kameleoon verfügt über ein eigenes Expertenteam für A/B-Tests. Es gibt außerdem weltweit jede Menge Spezialisten, welche Ihr Testprogramm unterstützden können. In unserem Kameleoon-Expertenverzeichnis haben wir viele der Leader auf dem Gebiet des A/B-Testings hervorgehoben.

Um eine effektive A/B-Testing-Strategie für Ihre Website zu entwickeln, ist es wichtig, eine Kultur des Experimentierens zu entwickeln.

2. Die richtigen Leute an Ihrer Seite

Der Aufbau eines starken CRO-Teams ist der Schlüssel zum Erfolg Ihres A/B-Testprogramms. Hier sind ein paar Rollen, die Sie besetzen sollten:

- Spezialisten für Personalisierungen und Projektmanager, die die Strategie strukturieren und das Projekt verwalten, indem sie die verschiedenen Profile und Ressourcen koordinieren.

- Entwickler, die sich um die Integration und den technischen Aspekt des Experiments kümmern.

- Designer mit soliden UX-Kenntnissen, um personalisierte Erlebnisse und an die Bedürfnisse der Besucher angepasste Schnittstellen zu schaffen.

3. Erstellung verschiedener A/B-Testprogramme

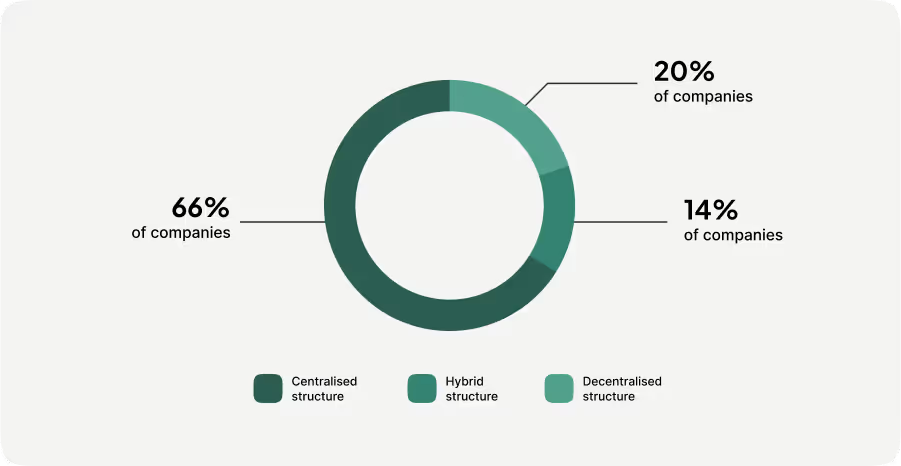

Bei der Einrichtung Ihres speziellen Experimentierteams können Sie sich von den drei Haupttypen von Organisationsstrukturen inspirieren lassen, die es heute in Unternehmen gibt:

- Eine zentralisierte Struktur, die die A/B-Testing-Strategie für das gesamte Unternehmen vorantreibt und den Experimenten je nach den Bedürfnissen der einzelnen Teams Priorität einräumt.

- Eine dezentralisierte Struktur mit Experten in jedem Team, die mehrere Projekte gleichzeitig durchführen.

- Eine hybride Struktur mit einer Experimentiereinheit und Experten in jedem Team.

9. Der Aufbau eines A/B-Testprogramms

Es können kleine bis große Unternehmen mit unterschiedlichen Ressourcen sinnvolle A/B-Tests durchführen. Wichtig ist hier nur, dass Sie einen zuverlässigen Plan befolgen.

Hier sind sieben Schritte zur Umsetzung Ihrer Teststrategie:

Schritt 1: Einbindung der Geschäftsführung

Die Erfahrung zeigt, dass die Zustimmung der Geschäftsführung zu einem neuen Testprogramm die Wahrscheinlichkeit erhöht, dass Sie die Testressourcen langfristig behalten können. Beginnen Sie damit, dass Sie von der Führungsebene Input zu den Testmöglichkeiten jener Kennzahlen erhalten, die die strategischen Ziele des Unternehmens unterstützen – mit anderen Worten, was im Fokus der Führungskräfte steht.

Wenn Ihre Führungskräfte skeptisch sind, sollten Sie Ihre Hypothesen zum Testen vorschlagen und ihnen anschließend die Ergebnisse präsentieren. Ob erfolgreich oder nicht, mit einer guten Analyse können Sie Ihnen aussagekräftige Ergebnisse aus Ihren ersten A/B-Tests vorlegen.

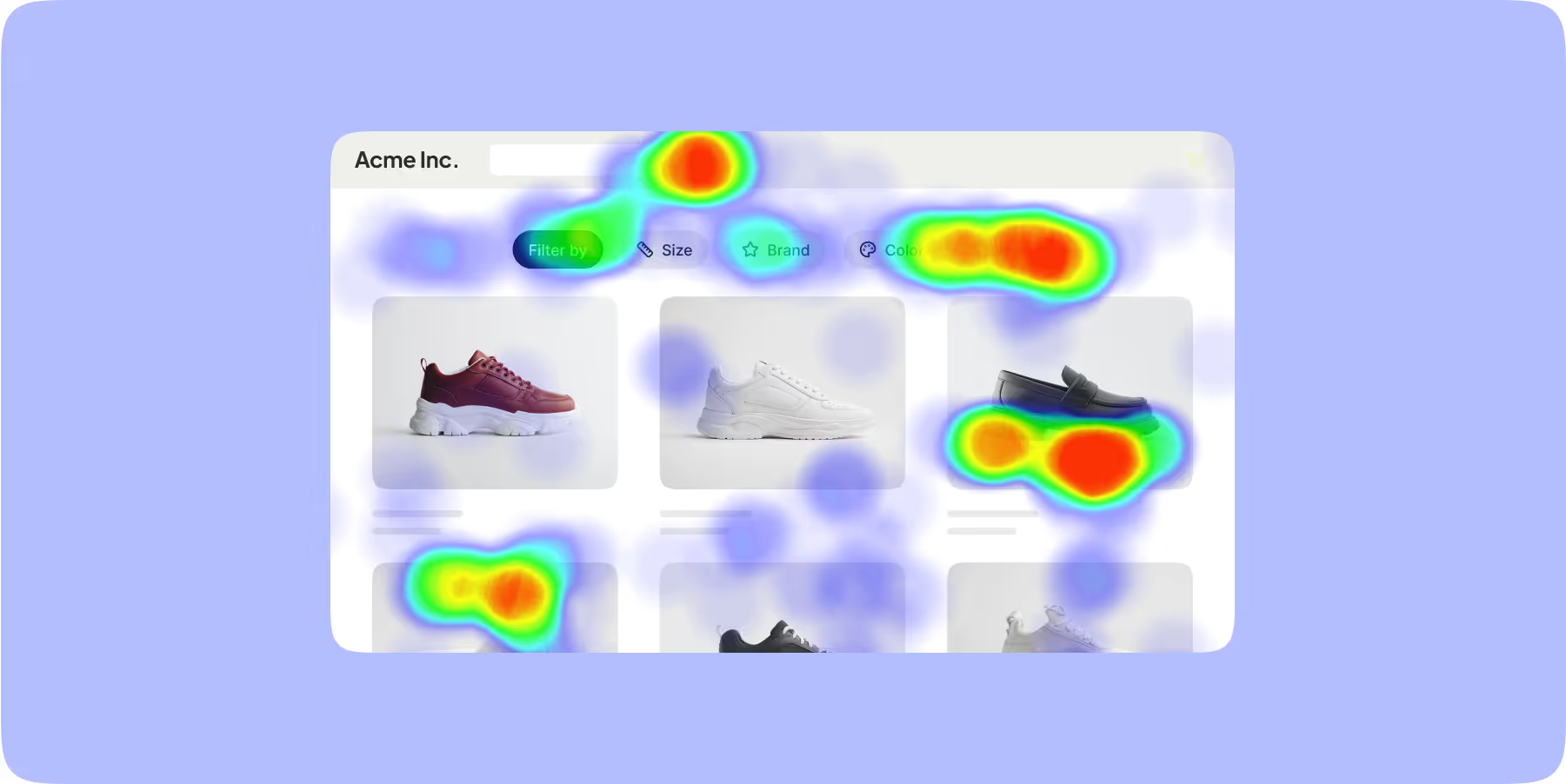

Schritt 2: Messung und Analyse der Website Performance

Der nächste Schritt besteht darin, sich Zeit für die Identifizierung von Optimierungsmöglichkeiten zu nehmen. Jede Website ist anders, daher müssen Unternehmen ihre Strategie basierend auf dem Verhalten ihrer Zielgruppe, ihrer Ziele und den Analyseergebnissen ihrer Website-Performance entwickeln.

Um Reibungspunkte auf Ihrer Website zu identifizieren, können Sie Tools zur Verhaltensanalyse wie Click-Tracking oder Heatmaps verwenden.

Schritt 3: Formulierung einer Hypothese

Sobald Sie die Reibungspunkte identifiziert haben, die Ihre Besucher von der Conversion abhalten, formulieren Sie Hypothesen, die Sie mit einem A/B-Test testen können.

Eine Hypothese ist eine fundierte Vermutung, die Sie über das Verhalten eines Kunden anstellen. Alle guten A/B-Tests werden auf der Grundlage glaubwürdiger Hypothesen entwickelt.

Im Folgenden erfahren Sie, wie Sie aus einer Hypothese ein Experiment erstellen können:

- Beobachtung: Die von Ihnen installierte Sticky Bar wird von den Besuchern kaum genutzt.

- Hypothese: Die Icons müssen deutlicher sein. Das Hinzufügen von Kontext könnte diesen Schwachpunkt verbessern.

- Geplantes Experiment: Hinzufügen eines Textes unter jedem Symbol.

Schritt 4: Prioritätensetzung für A/B-Tests und Erstellung einer Testing-Roadmap

Um eine effektive A/B-Test-Roadmap zu implementieren und überzeugende Ergebnisse zu erzielen, ist es wichtig, Prioritäten für Ihre Aktivitäten zu setzen.

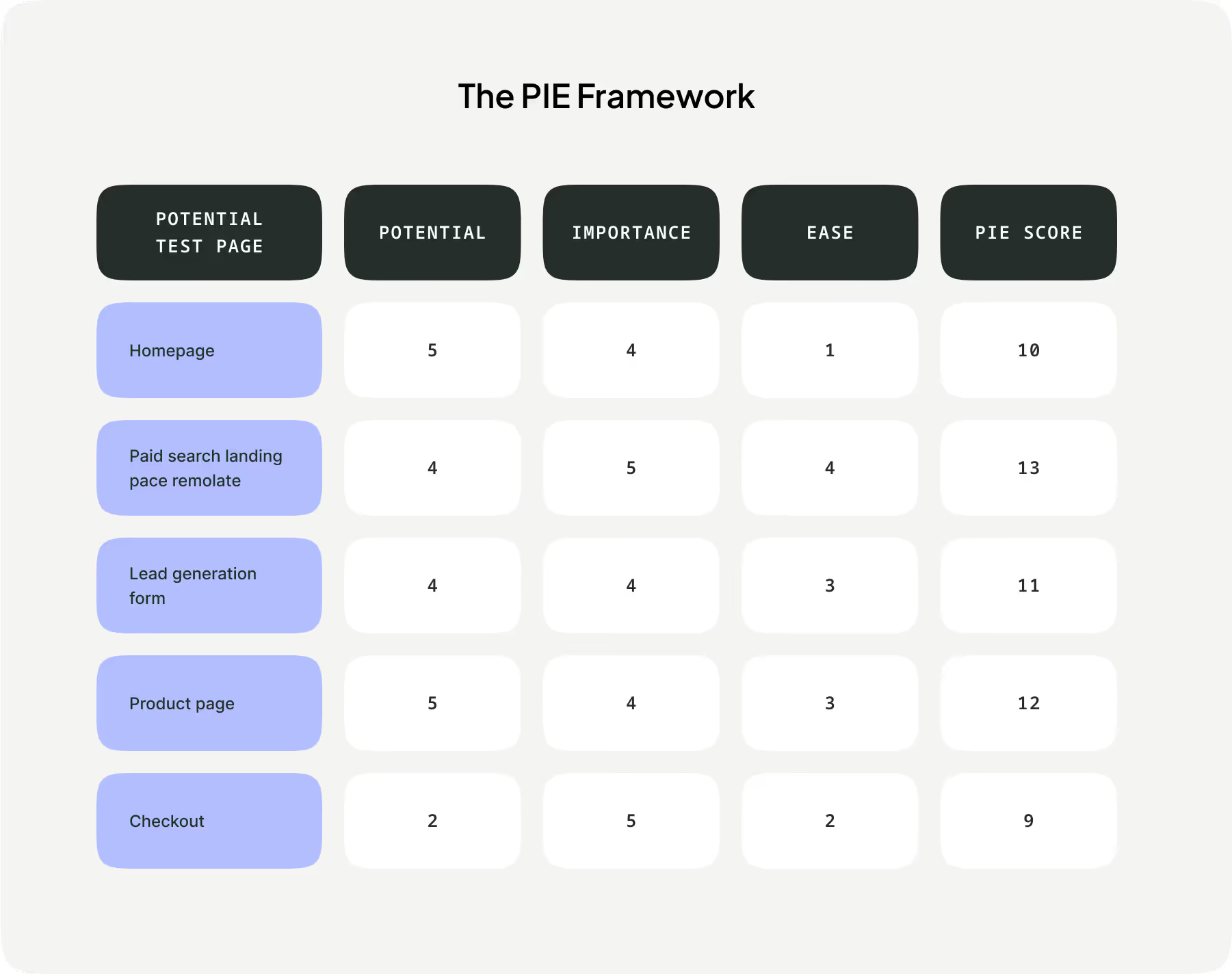

Um Prioritäten zu setzen, können Sie Ihre Testideen mithilfe des von WiderFunnel entwickelten Pie Framework nach drei Kriterien von 1 bis 10 einstufen:

- Potenzial: Auf einer Skala von 1 bis 10, wie sehr können Sie diese Seite verbessern?

- Wichtigkeit: Welchen Wert hat der Traffic (Volumen, Qualität) auf dieser Seite?

- Leichte Umsetzung: Wie einfach ist es, den Test durchzuführen (10 = sehr einfach, 1 = sehr schwierig)?

Mit dem Zusammenzählen der drei Bewertungen, werden Sie wissen, mit welchen Tests Sie starten sollten.

Schritt 5: Testen

Sobald Sie die Vorbereitungen abgeschlossen haben, können Sie mit dem A/B-Test beginnen. Denken Sie daran, dass Sie Ihren Test nicht mehr bearbeiten sollten, wenn er bereits läuft.

Schritt 6: Ergebnisse des A/B-Tests auswerten

Es ist sehr wichtig, die Testergebnisse zu analysieren und zu interpretieren. Schließlich geht es bei A/B-Tests darum, zu lernen und Entscheidungen auf der Grundlage der Analyse Ihrer Experimente zu treffen.

Für eine effektive Analyse Ihrer Ergebnisse:

- Lernen Sie, falsch positive Ergebnisse zu erkennen,

- Legen Sie repräsentative Besuchersegmente fest,

- Testen Sie nicht zu viele Varianten auf einmal,

- Geben Sie eine Testidee nicht nach einem Fehlschlag auf.

Schritt 7: Wiederholen

Sobald Sie die Ergebnisse gesammelt und analysiert haben, müssen Sie das, was Sie über Ihre Kunden und ihre Customer Journey gelernt haben nutzen, um Ihre nächste Testrunde zu formulieren.

Bei A/B-Tests und Experimentierstrategien geht es um den Aufbau von Feedbackschleifen. Erkenntnisse führen zu weiteren Erkenntnissen, Optimierungen führen zu weiteren Optimierungen und steigendes Engagement führt zu noch mehr Engagement.

Sobald Ihre letzte Testrunde abgeschlossen ist, arbeiten Sie an der nächsten und halten den Schwung aufrecht.

10. Tipps zur Verbesserung Ihres A/B-Testprogramms

Eine der effektivsten Möglichkeiten, ein bestehendes Experimentierprogramm zu verbessern, besteht darin, Tests für bestimmte Zielgruppensegmente zu entwickeln. Wenn Sie Ihre gesamte Zielgruppe testen, dann testen Sie in Wirklichkeit den Durchschnitt – einen idealisierten Durchschnittskunden, den es in Wirklichkeit gar nicht gibt.

Natürlich ist es nicht machbar, jeden einzelnen Kunden zu testen. Die Qualität Ihrer Ergebnisse wird sich aber erheblich verbessern, wenn Sie Ihre Testzielgruppe in einige vernünftige Segmente unterteilen.

Die Zielgruppe kann nach den folgenden Segmenten sortiert werden:

- Nach demografischen Merkmalen,

- Nach geografischen Aspekten,

- Nach neuen vs. wiederkehrenden Besuchern,

- Nach Besuchern mit mobilen Geräten vs. zu Desktop-Benutzern.

Jedes dieser Segmente hat seine eigenen Motive. Wenn Sie diese gezielt ansprechen, erhalten Sie aussagekräftigere Einblicke in ihr Verhalten und ihre Kaufmuster. Im Folgenden finden Sie einige bewährte Verfahren, die Sie bei der Optimierung Ihres Testprozesses für die Arbeit mit verschiedenen Zielgruppensegmenten beachten sollten.

Einfach beginnen

Übertreiben Sie es nicht mit zu fein abgestuften Zielgruppensegmenten. Beginnen Sie stattdessen mit einigen vernünftigen Unterteilungen für Tests, wie den oben vorgeschlagenen übergeordneten Segmenten.

Die meisten Produktmanager können ihre Daten zum Beispiel leicht in neue und wiederkehrende Besucher unterteilen.

Segmente verfeinern

Das Experimentieren ist ein iterativer Prozess, das heißt, Sie müssen Schritt für Schritt vorgehen. Sobald Sie aussagekräftige Ergebnisse für diese übergeordneten Segmente haben, können Sie detaillierter vorgehen und versuchen, wichtige Nuancen in immer kleineren Segmenten zu ermitteln.

Aktuelle Daten bevorzugen

Die Wirtschaft entwickelt sich schnell. Ihre Experimentierdaten sollten sich noch schneller entwickeln.

Jemand, der Ihre Website vor 90 Tagen für eine einzige, lange Sitzung besucht hat, ist kein guter Vergleich zu jemandem, der Ihre Website diese Woche dreimal besucht hat.

Stellen Sie sicher, dass Ihre Segmente Besucher berücksichtigen, die Ihre Website innerhalb desselben Zeitraums nutzen und stellen Sie idealerweise sicher, dass der Zeitrahmen so aktuell wie möglich ist.

11. Häufige A/B-Testing-Fehler und wie sie vermieden werden können

A/B-Tests können einen großen Nutzen bieten und sind für Fachleute aus dem digitalen Bereich leicht zu erlernen. Es gibt jedoch einige Fallstricke, auf die Sie stoßen können, wenn Sie zum ersten Mal A/B-Tests beginnen.

Hier sind einige der häufigsten Herausforderungen, mit denen A/B-Testende konfrontiert werden können und wie man sie überwindet.

Mangelnde Recherche

Selbst Ihr allererster Test erfordert einige Nachforschungen. Ihre Tests müssen auf dem Verständnis des Nutzerverhaltens beruhen und durch vorhandene Daten gestützt werden.

Diese Daten können einfache Kennzahlen wie direkte Conversion Rates, Seitenaufrufe oder die Anzahl der Unique Visitors darstellen. Dennoch ist es ratsam, auch bei den kleinsten und frühesten Tests auf eine ausreichende Datenmenge zu achten und nicht ausschließlich auf reine Intuition zu setzen.

Zu kleine Stichprobengrößen

Ein Test mit zu wenigen Teilnehmern ist statistisch nicht signifikant. Mit anderen Worten: Sie werden nicht genügend Daten sammeln können, um aussagekräftige Ergebnisse zu erhalten. Ein Test ist nur dann effektiv, wenn Sie auf eine aussagekräftige Stichprobe von Unique Visitors zurückgreifen können.

Die Größe der Stichprobe, die Sie benötigen, hängt von mehreren Faktoren ab:

- Gesamtzahl der Website-Besucher,

- Aktuelle Conversion Rate,

- Minimum Detectable Effect (MDE), den Sie erwarten – oder die minimale Änderung des Nutzerverhaltens, die Ihre Testversion Ihrer Meinung nach hervorrufen wird.

Ändern von Einstellungen und Parametern während des Tests

Das passiert jedem: Sie starten einen Test und stellen ein paar Tage später fest, dass Sie ihn besser hätten strukturieren können. Wenn Sie jedoch mitten im Test Änderungen vornehmen, beeinträchtigen Sie die Qualität Ihrer Ergebnisse, da Sie die Benutzer nicht mehr denselben Testbedingungen aussetzen.

Akzeptieren Sie stattdessen, dass es nie einen perfekten Test geben wird. Konzentrieren Sie sich darauf, verlässliche Ergebnisse aus Ihrem aktuellen Test zu erhalten, analysieren Sie die Ergebnisse und verbessern Sie den nächsten Test.

Keine Prüfung auf Sample Ratio Mismatch (SRM)

Ein Sample Ratio Mismatch (SRM) liegt vor, wenn eine Variante in einem bestimmten Test unbeabsichtigt weit mehr Traffic erhält als die andere.

Wenn Ihr Stichprobenverhältnis nicht ausgeglichen ist, sind Ihre Ergebnisse nicht signifikant.

Glücklicherweise können Sie mit dem Goodness-of-Fit-Test für Ihre Stichprobengrößen bestätigen, dass sie nahe genug beieinander liegen, um statistisch signifikante Ergebnisse zu erzielen. Sie können auch den SRM-Checker von Kameleoon verwenden, um sicherzustellen, dass Ihre Ergebnisse frei von SRM sind.

Nicht-Berücksichtigung von Intelligent Tracking Prevention (ITP)

Die Intelligent Tracking Prevention (ITP) von Apple begrenzt die Speicherung von Erst- und Drittanbieter-Cookies auf sieben Tage und setzt damit die von Plattformen wie Google Analytics festgelegten Standard-Ablaufdaten außer Kraft. Ein Benutzer, der die Website an einem Montag besucht und am Dienstag der darauffolgenden Woche wiederkommt, wird als völlig neuer Besucher behandelt.

Wenn Sie ITP nicht berücksichtigen, wird Ihre Kennzahl für neue Besucher in Google Analytics für jeden Safari-Verkehr völlig ungenau sein. Darüber hinaus werden viele andere Kennzahlen ebenfalls verzerrt, z. B. die Anzahl der Unique Visitors oder die Kaufdauer.

Suchen Sie nach einer Experimentierplattform, die lokale Speicher (LS) für Cookies verwendet, so wie zum Beispiel Kameleoon. Dadurch werden ITP-Beschränkungen umgangen und Sie erhalten bessere Daten über Ihre gesamte Besucherpopulation.

Testergebnisse falsch auswerten

Es spielt keine Rolle, ob Ihr Test erfolgreich war. Wenn Sie sich nicht die Zeit nehmen, Ihre Ergebnisse zu analysieren und zu verstehen, warum Ihr A/B-Test erfolgreich war oder fehlgeschlagen ist, werden Sie nichts wirklich verbessern.

So gesehen ist jeder Test, bei dem Sie statistisch signifikante Ergebnisse generieren und sich die Zeit nehmen, sie zu analysieren, ein Erfolg – Sie erfahren etwas Neues über Ihre Besucher.

Es spielt keine Rolle, dass Ihre Variante nicht mehr Conversions erzielt hat. Wenn Sie verstehen, warum dies nicht der Fall war, haben Sie Ihr Verständnis für die Customer Experience verbessert.

Keine Experimentierkultur entwickeln

Eine einzige Person kann nicht ein ganzes Experimentierprogramm tragen. Es erfordert Unterstützung von oben und von unten im gesamten Unternehmen.

Ihre Marketing-, Produkt-, Design-, IT- und anderen Teams müssen alle an einem Strang ziehen. Manchmal braucht es nur einen einzigen Befürworter, um das Experimentierprogramm zu starten. Jedoch benötigen Experimente Zeit, um ihren Wert zu zeigen.

12. Worauf bei einer A/B-Testing-Plattform geachtet werden sollte

Bei der Evaluierung verschiedener A/B-Testing-Plattformen sollten Sie nach solchen suchen, die Ihren Testprozess so gut wie möglich unterstützen. Natürlich sind einzelne technische Funktionen wichtig, das Experimentieren aber ist ein strenger Prozess – und Sie brauchen prozessorientierte Tools.

Um Ihnen die Bewertung verschiedener Testlösungen zu erleichtern, haben wir die wesentlichen Funktionen nach den Punkten im Testprozess gegliedert, an denen Sie sie benötigen. Suchen Sie nach einer Testlösung, die so viele Probleme Ihres Teams wie möglich löst.

Zieleinstellung

Wie in unserem Abschnitt über die A/B-Teststrategie erläutert, müssen Sie vor der Konfiguration spezifischer Tests zunächst die Zustimmung der Geschäftsführung einholen und die Ziele für Ihr Testprogramm festlegen. Dieser Schritt ist entscheidend, um sicherzustellen, dass Ihre Tests die richtigen Besucher ansprechen.

Welche User Experience möchten Sie verbessern? Sie können zum Beispiel auf einer Landingpage die Call-to-Action-Varianten A und B testen. Welche KPIs möchten Sie in diesem Fall messen? Legen Sie Ziele für die Nutzerbindung fest (die Anzahl der Klicks auf die CTA) und prüfen Sie, welche Variante am besten abschneidet.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Große Auswahl an messbaren Test-KPIs: Klicks auf ein bestimmtes Seitenelement, Scrolls pro Seite, Seitenaufrufe, Verweildauer pro Seite, Verweildauer auf der Website oder die Anzahl der aufgerufenen Seiten.

- Die Möglichkeit, benutzerdefinierte Ziele zu erstellen: personalisierte E-Commerce-Transaktionen mit Attributen wie Transaktions-ID, Bestellbetrag und Zahlungsmethode.

Erweiterte Zielgruppensegmentierung

Sie müssen Ihre Zielgruppe gut kennen, um qualitativ hochwertige Tests für Ihre Website oder App durchzuführen. In der Regel möchten Sie keine Tests mit Ihrer gesamten Zielgruppe durchführen, denn das bedeutet, dass Sie ein verwässertes durchschnittliches Besucherprofil testen, welches nicht sehr aussagekräftig ist.

Daher müssen Sie in der Lage sein, Ihre Besucher zu segmentieren, bevor Sie A/B-Tests durchführen.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Sammlung von Besucherdaten in Echtzeit,

- Eine Targeting-Funktion, die Besucher anhand von verhaltensbezogenen, technischen oder kontextbezogenen Kriterien segmentieren kann,

- Erstellung von Segmenten anhand der Datenquelle: Landingpage, verweisende Website oder Art des Traffics,

- Erstellung von Segmenten auf der Grundlage des digitalen Fußabdrucks: Browsersprache, Gerätetyp, IP-Adresse, Bildschirmauflösung oder Browserversion,

- Segmenterstellung auf Basis der Browser-Historie: neue vs. wiederkehrende Besucher oder Kundentyp,

- Erstellung von Segmenten auf der Grundlage von Datum und Uhrzeit oder anderen externen Informationen,

- Segmenterstellung auf der Grundlage von Daten, die durch App-Integrationen bereitgestellt werden,

- DSGVO-konforme Segmentierung.

Experimentation Trigger

A/B-Tests müssen durch bestimmte Verhaltensweisen der Nutzer oder Browser-Ereignisse aktiviert werden. Bei Experimenten werden diese als Trigger bezeichnet. Daher benötigen Sie eine Experimentierlösung, die Trigger für die Interaktion Ihrer Nutzer mit Ihrem Dienst bereithält.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Seiten-Trigger: die Anzahl der Seitenaufrufe, die Verweildauer auf der Website und das Vorhandensein von Elementen auf der Seite,

- Allgemeine Trigger: z. B. Mouse-out-Events und andere spezifische API-Ereignisse.

Einfach zu erstellende Elemente

Sobald Sie die Ziele festgelegt, die Zielgruppensegmente identifiziert und die Trigger für Ihren A/B-Test bestimmt haben, können Sie das Experiment selbst erstellen. Das bedeutet, dass Sie die Grafiken erstellen, die richtigen Parameter festlegen und den Start des Experiments verwalten müssen. Ihre A/B-Testlösung muss es Ihnen ermöglichen, problemlos Versionen der zu testenden Elemente zu erstellen.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Ein benutzerfreundlicher Grafik-Editor für die Erstellung benutzerdefinierter Elemente,

- Möglichkeit zur Aktivierung des Editors als WYSIWYG-Overlay auf jeder Seite, online oder offline,

- Die Möglichkeit, die Seiten Ihrer Website wie ein Benutzer zu durchsuchen, um die Erfahrung zu überprüfen,

- Automatische Erkennung von Elementtypen (z. B. Block, Bild, Link, Schaltfläche, Formular),

- Kontextualisiertes Menü mit Optionen für jeden Elementtyp,

- Alternative Programmierschnittstelle für Entwickler, die CSS und JavaScript unterstützt,

- Widget-Bibliothek,

- Ein Simulationstool zur Überprüfung von Testparametern, wie z. B. die Anzeige von Varianten, Targeting, KPIs und mögliche Konflikte mit anderen Experimenten,

- Integrationen mit den wichtigsten Kategorien von Martech-Anbietern, wie Analytik, CDP/DMP, Automatisierung, Einwilligung, CMS und E-Mail.

Erweiterte Testerstellung- und Verwaltung

A/B-Tests können einfach sein, wie zum Beispiel das Experimentieren mit der Farbe der CTAs auf Ihren Produktseiten.

Sie können aber auch viel komplexer sein, wie z. B. ein Test Ihres gesamten Conversion-Funnels. Sie können Ihre Experimentierplattform auch für andere wichtige, damit verbundene Funktionen nutzen, z. B. für die dynamische Verwaltung der Traffic-Verteilung zur Vermeidung von Sample Ratio Mismatches.

Einige Experimentierteams möchten technische oder groß angelegte Projekte intern mit ihren Entwicklungsteams durchführen. In diesem Fall ist es wichtig, sich auf eine Testlösung mit robusten Entwicklungs- und Integrationsfunktionen zu verlassen.

Das serverseitige Testmanagement ist für die Teststrategien einiger Teams unerlässlich. Serverseitige und hybride Testdienste testen Ihre Optimierungshypothesen in der Backend-Infrastruktur und im Code und nicht in den Browsern Ihrer Benutzer. Und doch bieten viele Tools dies nicht an.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Verwaltung multivariater Tests,

- Multi-Site- und Multi-Domain-Verwaltungsoptionen,

- Benutzerdefiniertes Attributionsfenster zur korrekten Zuordnung von Conversions auf der Grundlage Ihres individuellen Verkaufszyklus,

- Verwaltung von Algorithmen für die Traffic-Zuweisung (für lineare oder Multi-Armed Bandit-Testing),

- Test-Planung,

- Feature-Flagging, mit dem Sie verschiedene Features auf der Grundlage von Regeln, Zeitplänen oder KPIs ausrollen können,

- Funktion für die geschätzte Testdauer,

- Serverseitige Testverwaltung,

- Logic-Caching,

- Umfassende Entwicklungstools (REST API und SDK-Bibliothek, Entwicklerportal),

- Automatische Anwendungsverwaltung,

- SDKs,

- API-Bibliothek.

Problemmanagement

Kein Experiment läuft jemals reibungslos ab und das ist auch in Ordnung. Wichtig ist, dass Sie über die notwendigen Tools verfügen, um Probleme zu bewältigen, wenn sie unweigerlich auftreten.

Unsachgemäß erstellte Tests können sich negativ auf die Performance Ihrer gesamten Website auswirken. Um dieses Risiko zu minimieren, sollten Sie eine Lösung wählen, die über eine für A/B-Tests optimierte Struktur verfügt.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Keine Flicker-Erzeugung,

- ITP-Verwaltung zur Durchführung von A/B-Tests unter Berücksichtigung der verkürzten Cookie-Lebensdauer von Apple,

- Automatische Verwaltung der Nutzerzustimmung.

Analyse der Ergebnisse

Nach der Datenerfassung ist Ihre Arbeit noch nicht getan. Jetzt kommt der wirklich wichtige Teil: die Analyse Ihrer Ergebnisse.

Sie müssen sich die Ergebnisse ansehen, entscheiden, welche Änderungen an Ihrer Website vorgenommen werden müssen und Ihren Fahrplan für die Optimierung der Conversion Rate aktualisieren. Dazu benötigen Sie leicht verständliche und anpassbare Reporting-Tools, mit denen Sie die für Sie wichtigen Testergebnisse verfolgen können.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- A/B-Testing-Berichtstool mit wichtigen Leistungsindikatoren (KPIs), z. B. Berechnung der Conversionverbesserung oder der damit verbundenen Genauigkeitsraten,

- Statistische Analyseoptionen, z. B. frequentistisch oder bayesianisch, Besucher nach Besucher, nach konvertiertem Besuch oder für alle gemessenen Conversions,

- Datenvisualisierungstools, einschließlich interaktiver Grafiken, Zeiteinteilung und Zoom,

- Personalisierte Berichte,

- Filter für Testkriterien,

- Vergleichende Ansicht mehrerer Zeiträume,

- Freigabetools – zum Beispiel eine Exportfunktion oder URL-Freigabe,

- Erstellung von Warnmeldungen auf der Grundlage von anpassbaren Geschäftskriterien,

- Ein System zur Entscheidungsunterstützung,

- Integration von Analyselösungen Dritter.

Unterstützung für Ihren gesamten Testprozess

Bei der Durchführung von Experimenten sollte man keine Alleingänge machen. Wie wir bereits erwähnt haben, ist beim Testen keine Zeit für Heldentaten. Sie brauchen eine breite organisatorische Unterstützung und die richtigen unterstützenden Tools und Dienstleistungen. Der Kundensupport Ihres Lösungsanbieters ist eine entscheidende Komponente.

Die Anforderungen an den Support sind je nach Erfahrungsgrad des Unternehmens und des Testprogramms unterschiedlich. Deshalb ist es wichtig, mit einem Anbieter zusammenzuarbeiten, der sich an Ihre spezifischen Bedürfnisse anpassen kann.

A/B-TESTING FEATURES, DIE ZU BERÜCKSICHTIGEN SIND:

- Für erfahrene Unternehmen die Möglichkeit, unabhängig mit Selbstbedienungs-Support-Tools zu arbeiten, z. B. Schulungen über Tutorials und ständiger Zugang zum Helpdesk,

- Ein dedizierter Customer Success Manager, der Ihrem Konto zugewiesen ist und Sie strategisch unterstützen kann,

- Ein dedizierter Technical Account Manager wird Ihrem Account für technischere Projekte zugewiesen,

- Die Möglichkeit, mit einem breiten Netzwerk von Agenturen zusammenzuarbeiten.

Durchführung von Datenschutzkonformen A/B-Tests

In vielen Branchen gelten Datenschutzbestimmungen. Wenn Sie im Finanz-, Gesundheits- oder Bildungswesen tätig sind, bedeutet das nicht, dass Sie keine A/B-Tests mit Ihren Kundendaten durchführen können. Es erfordert nur zusätzliche Vorbereitung.

Das Gleiche gilt für alle Unternehmen, die unter Gesetze zur Datensicherheit fallen, wie z. B. die DSGVO, GDPR der Europäischen Union (EU) oder die CCPA von Kalifornien.

Unternehmen, die unter diesen Einschränkungen arbeiten, können und sollten ihre digitalen Dienste optimieren. Im Folgenden finden Sie einige der wichtigsten Informationen zur Durchführung datenschutzkonformer A/B-Tests.

- Jegliches Experimentieren ist besser als gar kein Experimentieren,

- Der Aufbau einer Experimentierkultur kann in regulierten Sektoren sogar noch wichtiger sein,

- A/B-Tests müssen keine personenbezogenen Daten (PII) verwenden,

- Verwenden Sie Experimentationtools, die für die Arbeit mit PII ausgelegt sind.

Vorschriften zwingen Design-, Produkt- und Marketingteams oft dazu, risikoscheu zu sein. Die Kunst besteht jedoch darin, akzeptable Risiken zu finden, die man beim Experimentieren mit der User Experience eingehen kann.

13. Der Beginn mit A/B-Testing

Wenn Sie Ihre Strategie auf A/B-Tests und gründliche Datenanalysen stützen, wird Ihr Unternehmen wettbewerbsfähiger und flexibler. Das Wichtigste ist jedoch, dass Sie hochwertiges, datengestütztes Feedback darüber erhalten, wie Ihre Kunden Ihre Website bewerten.

Die Implementierung einer A/B-Testing-Plattform verschafft Ihnen neue, aussagekräftige Einblicke in die Customer Journey und bietet greifbare Vorteile, wie z. B. geringere Absprungraten und höhere Conversion Rates.

Aber wie wählen Sie eine Testplattform aus, die Ihren Anforderungen und den Fähigkeiten Ihres Teams entspricht?

Die A/B-Testing-Checkliste von Kameleoon gibt Ihnen die Informationen, die Sie brauchen, um die richtige Wahl zu treffen.

FAQ

In der Regel testen Sie zwei Versionen: Ihre ursprüngliche Version, die A-Version – auch Kontrollversion genannt – gegen die modifizierte B-Version, von der Sie annehmen, dass sie besser funktioniert. Bevor Sie Ihren A/B-Test erstellen, entscheiden Sie, welche Kennzahlen Sie messen möchten, damit Sie quantifizieren können, was „besser“ in Ihren Testergebnissen bedeutet.

Bei einem A/B-Test werden den Nutzern mehrere Versionen einer Webseite oder einer App präsentiert, um festzustellen, welche Version zu besseren Ergebnissen führt. A/B-Tests sind eine relativ einfache Methode, um die Nutzerbindung zu verbessern, ansprechendere Inhalte anzubieten, die Absprungrate zu senken und die Conversion Rate zu erhöhen.Jedes Mal, wenn Sie einen A/B-Test durchführen, erfahren Sie mehr darüber, wie Ihre Kunden mit Ihrer Website oder App umgehen. Mit der Zeit schafft ein umfassendes Testprogramm eine Feedbackschleife, die Ihre Inhalte immer effektiver macht und eine Grundlage für neue, noch aufschlussreichere Tests bietet.

A/B-Tests können so einfach oder so komplex sein, wie Sie wollen. Sie können zum Beispiel einfache Versionstests durchführen, bei denen Sie die Wirksamkeit einer neuen B-Version mit einer ursprünglichen A-Version vergleichen. Sie können auch multivariate Tests (MVT) durchführen, bei denen Sie die Wirksamkeit verschiedener Kombinationen von Änderungen vergleichen. Sie können auch drei oder mehr Varianten gleichzeitig testen, was als A/B/n-Test bezeichnet wird.

A/B-Tests sind eine unglaublich vielseitige Methode, um Erkenntnisse über die Websitebesucher zu gewinnen. Sie kann für viele Teams wertvoll sein, darunter Marketing-, Produkt- und Growthteams. Marketingteams können A/B-Tests erstellen, um herauszufinden, welche Kampagnen Kunden effektiv in den Trichter führen. Produktteams können die Benutzerbindung und das Engagement testen. Growthteams können mit A/B-Tests ganz einfach verschiedene Komponenten der Customer Journey bewerten.